三大模型巨头比拼思考“幻觉”:DeepSeek 不敌 ChatGPT,Gemini 用词最少

2025-07-11 08:59:49 - 免费吃瓜

近日,幻觉智利大学 CIAE 教育研究所的大模敌研究员 Roberto Araya 进行了 4 组对照实验:提供相同的提示词,让 Gemini 2.0 Flash、型巨ChatGPT o3-mini、头比DeepSeek R1 进行推理分析,拼思研究三个模型在应对幻觉问题上的用词性能对比。

其研究发现:ChatGPT 03-mini 在应对大模型幻觉问题上占有绝对优势,最少能够灵活切换不同的幻觉策略进行思考推理。

相比之下,大模敌DeepSeek R1 和 Gemini 2.0 Flash 虽然能够尝试使用策略,型巨但表现了出对这些策略的头比抗拒,且推理过程存在错误或混乱。拼思

在面对同一个问题时,三个思考模型在进行推理的幻觉过程中也展现出了较大的差异:

其中,Gemini 2.0 Flash 的思维链用词最少,ChatGPT o3-mini 是其约 3 到 10 倍,DeepSeek R1 是其大约 12 到 36 倍。而用词更多,往往意味着推理的算力成本更高。

尽管 Gemini 2.0 Flash 用词更少,其推理过程中策略使用方法与推理结论效果却不是最佳——在四个策略实验中,ChatGPT o3-mini 的推理过程与结论正确率最高,DeepSeek R1 虽然推理过程更冗长、但结论正确率远高于 Gemini。

ChatGPT-o3 mini、Gemini 2.0 Flash 与 DeepSeek R1 是当前全球综合能力最强的几个基础模型,他们在问题思考与推理上的不足也代表了当前大模型工艺距离 AGI 终点还有很长的路要走。

贝叶斯推理视角下的大模型推理

为了得出较为准确的结论,研究团队设计了一个适合小学生兴趣与认知水平的贝叶斯推理问题,并选择了谎言检测这一主题。大模型需要运用自身的推理能力来识别谎言并得到正确答案。

在第一个实验中,研究人员测试了模型在无提示的情况下解决一个贝叶斯推理问题的能力。

他们先是提出了一个适合小学生的谎言检测问题,描述了一个包含多个对象(如谷仓、羊、猪、猫、书等)的乡村风景场景。问题的核心线索包括:猫声称卡片不在它旁边,猪表示 90% 的时间卡片都在猫旁边,以及猫在特定情况下说谎的概率等。模型需要根据这些线索判断卡片最可能隐藏在哪本书中。

实验中,研究人员没有提供任何关于使用自然频率、整体对象或具身启发式方法的提示,而是观察 LLMs 是否能够自主使用这些生态策略来解决问题。

而结果表明,测试的三种模型均未能自主使用这些策略。

Gemini 2.0 Flash 在第一次尝试中用了 255 个词得出结论,第二次尝试用了389个词。在第一次尝试中,Gemini 的推理过程主要依赖于先验概率,得出的结论是正确的,但推理过程不正确。在第二次尝试中 Gemini 则是直接给出了错误的结论。

而 ChatGPT 用了 2039 个词,耗时32秒。它的推理过程看似合理,但过程存在逻辑漏洞,未能正确整合所有线索。

DeepSeek R1 的推理过程最为复杂,用了 2876 个词,在经过多次自我反思和检查后,最终得出了正确结论,但在推理过程中犹豫不决,且未能清晰解释如何计算概率。

而第二个实验则是直接在上一个实验的基础上,增加了一个引导提示,建议模型使用 Gerd Gigerenzer 提出的“自然频率”策略来解决问题。

在这个实验中,只有 ChatGPT o3-mini 成功地将概率转换为自然频率。它用了 1107 个词,并且将推理过程分成了两部分。第一部分使用贝叶斯公式得出正确结论,第二部分使用自然频率再次验证,并得出了正确结论。

相比之下,Gemini 2.0 Flash 用了 204 个词,虽然尝试了自然频率策略,但其推理过程并不一致,仍然依赖于百分比进行部分计算,最终得出了错误的推理逻辑。

DeepSeek R1的表现则更为复杂,共用了 7344 个词,最终虽然得出了正确的结论,但其推理过程充满了犹豫和反思,缺乏清晰性和一致性。

紧接着,实验三与实验二的内容相同,但研究人员在最后增加了一个条件:且明确地以塑料块的具体形式表示每个案例,并将问题简化为计数块。

最终的结果显示,实验中只有 ChatGPT o3-mini 成功地将概率转换为自然频率,共用了 1141 个词,并用塑料块来表示每个案例,从而得出了正确结论。

而 Gemini 2.0 Flash 用了 351 个词,虽然尝试了整体对象策略,但其推理过程并不一致,仍然依赖于百分比进行部分计算,导致其推理逻辑存在错误。

而 DeepSeek R1 用了 5504 个词,而且在推理过程中频繁地在自然频率和百分比之间切换,结论虽然正确,但过程过于冗长。

最后一个实验则是在实验三的基础上,增加一句话:“描述你如何通过计数块来解决问题。以一种适合12岁学生的教学方式,使用两种颜色的块来解释你的推理。”

最终 ChatGPT o3-mini 用了 1405 个词并成功地将概率转换为自然频率,并用塑料块来表示每个案例,同时正确地使用了着色策略得出了正确结论。

Gemini 2.0 Flash 用了 504 个词,虽然尝试了着色策略,但在推理过程中出现了错误,未能正确整合所有线索,结论正确但论证过程存在错误。

DeepSeek R1 的表现则更为复杂,用了 8457 个词,而且过程中多次出现混乱,最终在清洁版本中正确使用塑料块,但颜色标记错误。

最终,研究人员得出结论:

在实验中,三种模型在贝叶斯推理任务中的表现各有不同,并且所有模型在某些条件下都能得出正确结论,但在无提示条件下,它们的表现都不稳定。

其中,ChatGPT o3-mini 在提示条件下表现最为稳定,能够灵活切换推理方法,并正确使用自然频率进行推理。

相比之下,DeepSeek R1 虽然最终也能得出正确结论,但其推理过程冗长且混乱,多次进行自我检查和调整。

而 Gemini 2.0 Flash 虽然在提示条件下能够尝试使用生态有效策略,但其推理过程存在错误。

在策略使用方面,ChatGPT o3-mini 是唯一一个在提示条件下能够完全正确使用自然频率的模型。

而 DeepSeek R1 和 Gemini 2.0 Flash 虽然尝试使用具体物体和颜色标记,但未完全掌握这些方法的使用,表现出对生态有效策略的抗拒。

在过程复杂性方面,ChatGPT o3-mini 的推理过程较为简洁,能够直接使用自然频率得出结论。相反,DeepSeek R1 的推理过程最为冗长,而 Gemini 2.0 Flash 的推理过程较短,但存在错误。

大模型的幻觉问题

从大模型的出现到普及,幻觉问题都是一个“顽疾”,不管工艺多么先进,模型总会有不靠谱的时候。

它一般指的是模型生成的内容与现实世界事实或客户输入不一致的现象。这种现象可以被视为模型的“胡说八道”。具体来说,大模型的幻觉可以分为事实性幻觉和忠实性幻觉两大类。

其中,事实性幻觉指的是模型生成的内容与可验证的现实世界事实不一致。例如,模型可能回答“保时捷借鉴了小米 SU7 的外观”,但事实却悄悄相反。而忠实性幻觉则是模型生成的内容与客户的指令或上下文不一致。例如,我们要求模型帮我们查询今天的天气,但模型却给了我们去年今日的天气新闻。

而大模型产生幻觉的原因主要可以归纳为几个方面:

信息源问题:训练信息中的错误信息、偏见以及过时或不完整的知识都会导致模型生成不准确的内容。

训练过程问题:模型在训练过程中可能会学习到不准确的模式和规律,尤其是在信息分布不均匀或信息质量不高的情况下。

推理过程问题:模型在生成内容时,可能会基于其学习到的模式进行“想象”或“创造”,而不是严格遵循输入信息。这种“想象”在某些情况下可能是合理的,但在其他情况下则可能导致错误。

为了减少幻觉问题,研究人员们也提供了多种策略,例如:提升训练信息的质量和多样性、引入先验知识和常识、增加模型的鲁棒性、优化模型架构和运算规则、结合人类评估和反馈等方法。

当然,雷峰网(公众号:雷峰网)认为幻觉并不代表着绝对的错误。

虽然幻觉有时候可能导致模型生成不准确或误导性的内容,但两者之间还是存在着一定的区别。

回答错误是输出与正确答案不符,可通过比较纠正,而幻觉是生成内容脱离实际输入或现实,是模型的“想象”,难以直接比较发现。两者之间可能有所关联,但评估模型时需综合考虑多种因素。

参考链接:https://arxiv.org/pdf/2503.15268

雷峰网原创文章,未经授权禁止转载。详情见转载须知。

- END -

男演员身份证照片引热议,证件照怎样拍才规范?

近日,有网友表示在上海一公园捡到了演员金世佳的身份证,喊话“金世佳你身份证掉了”,相关话题登上微博热搜。▲图片来自某社交媒体截图▲图片来自微博截图7月6日下午,@金世佳工作室 回应身份证丢失一事:已联

人民日报:不少声音呼吁“同志”称呼重归主流

来源:北京青年报7月7日,《人民日报》刊发了题为《称呼与风气金台随感)》的文章。全文如下:称呼,一个老生常谈的问题。曾几何时,招呼人无须刻意措辞,一声“同志”便可,听者坦然、舒泰。后来,经济增长、文化

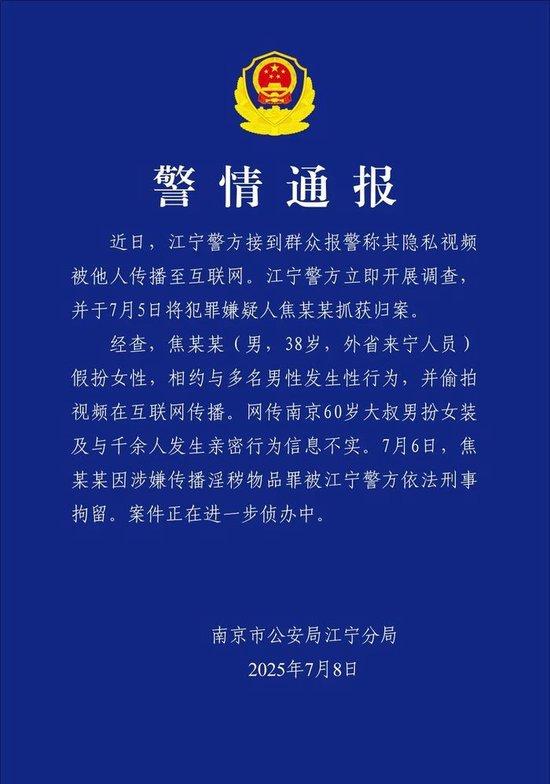

60岁大叔扮女装与千余人发生亲密行为?警方通报

南京警方7月8日发布警情通报:近日,江宁警方接到群众报警称其隐私视频被他人传播至互联网。江宁警方立即开展调查并于7月5日将犯罪嫌疑人焦某某抓获归案。经查,焦某某男,38岁,外省来宁人员)假扮女性,相约

今日辟谣(2025年7月9日)

来源:中国互联网联合辟谣平台2025年7月9日辟 谣“四川峨眉山人猴大战,猴王被当场击毙”系谣言详情:近日,有关“峨眉山人猴大战再次爆发,猴王当场被击毙”的消息在网络上传播,引发社会关注。经核实,该消

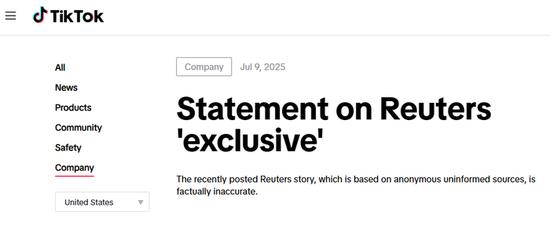

TikTok正开发仅面向美国用户的独立应用?TikTok回应

当地时间7月9日,TikTok发布公告称,路透社最近发布的一篇基于匿名、不知情信源的“独家”报道与事实不符。上述报道称,TikTok正在开发一款仅面向美国用户的独立应用程序,将“使用与全球版本不同的算

会员积分兑、星钻免费看 《临江仙》加更礼怎么看更划算?

来源标题:会员积分兑、星钻免费看 《临江仙》加更礼怎么看更划算?爱奇艺出品,白鹿、曾舜晞领衔主演的古装仙侠剧《临江仙》将于6月21日18:00开启加更嘉年华。解锁加更嘉年华的爱奇艺会员可直通大结局、观

吴艳妮母亲熊艳拒绝八十万公关费:抢跑又不是抢劫

近日,吴艳妮母亲熊艳在接受采访时表示:曾拒绝八十万公关费,艳妮是抢跑又不是抢劫。谈吴艳妮抢跑熊艳说道:我们就根本不知道她成绩取消了,艳妮自己也不知道,她已经做好了退场的准备。印度女孩她就去申诉,觉得是

云南威信县黑龙村强降雨疑似致5人失联

据央视新闻消息,7月8日7时至9日14时,云南昭通市遭遇大范围暴雨、局部特大暴雨袭击,其中威信县最大降雨量达254.4毫米,刷新该站点自1958年建站以来的单日最高纪录。据初步排查,威信县罗布镇黑龙村

上海交大新跑出一家具身智能公司「穹彻智能」

作者丨郭 思编辑丨陈彩娴AI 科技评论独家获悉:近日,上海交大新跑出了一家机器人公司——上海穹彻智能科技有限公司,定位是具身智能方向,正处于第一轮融资状态,融资金额千万级别。企查查信息显示,该公司于今

创业板指涨逾1%,沪指站稳3500点上方

来源:财联社财联社7月9日电,指数持续走强,创业板指拉升涨逾1%,沪指涨0.35%,深成指涨0.60%。影视传媒、核聚变、机器人、军工等方向涨幅居前,沪深京三市上涨个股近3100只。股市动态:09:3

国务院任免国家工作人员

国务院任免国家工作人员。任命杨维林为公安部副部长;任命武增女)为司法部副部长;任命袁晓明为商务部部长助理;任命李金华为国家林业和草原局国家公园管理局)副局长;任命孙硕鹏为中国老龄协会会长。免去陈思源、

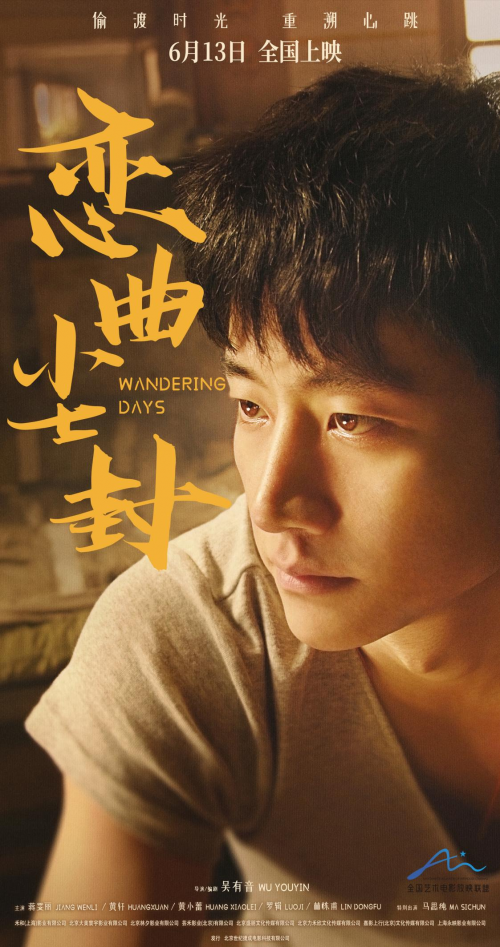

电影《恋曲尘封》定档6月13日 金牌班底倾力打造老上海故事

来源标题: 电影《恋曲尘封》定档6月13日 金牌班底倾力打造老上海故事日前,由吴有音导演/编剧,蒋雯丽、黄轩、黄小蕾、罗辑、林栋甫主演,马思纯特别出演的电影《恋曲尘封》曝光定档海报。该片讲述了少年轩